O ChatGPT, famoso pela sua capacidade de gerar texto, agora está em evidência pelo seu novo recurso de criação de imagens e deepfakes, que geraram bastante discussão. A ferramenta lançada pela OpenAI está sendo tão usada que isso afeta o funcionamento básico do ChatGPT, prejudicando a experiência dos usuários.

Mas não é só isso que está chamando a atenção no mundo da inteligência artificial. O modelo de vídeo Runway Gen-4 permite que você crie clipes incríveis a partir de apenas um texto e uma foto. Ele mantém a continuidade de personagens e cenários, algo inovador que poucos poderiam imaginar.

Os vídeos que a Runway apresentou reuniram a galera, já que qualquer pessoa pode criar clipes de qualidade cinematográfica com essas ferramentas, caso estejam em funcionamento adequado. No mínimo, a IA pode ajudar a diminuir os custos de efeitos especiais em muitos filmes.

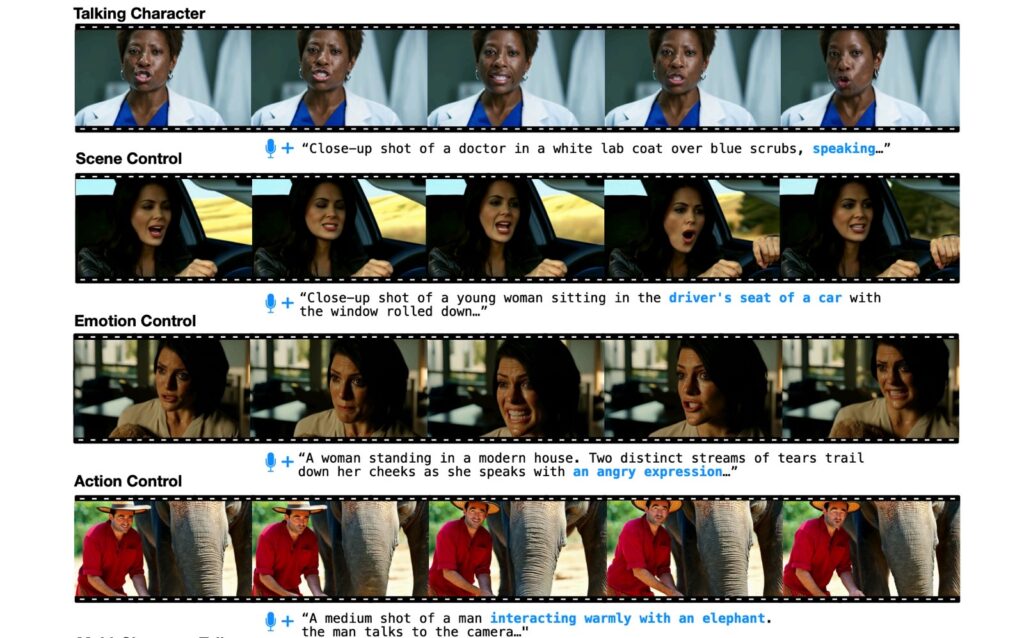

Além do Runway, a Meta também está investindo pesado em sua própria tecnologia, chamada MoCha. Esse produto faz com que personagens de vídeo se movimentem e falem, a ponto de enganar quem assistir. É um verdadeiro avanço!

MoCha não é só um erro de escrita para “mocha”, mas sim uma abreviação para “Movie Character Animator”. É um projeto de pesquisa da Meta em parceria com a Universidade de Waterloo. A proposta do modelo é simples: você dá um texto descrevendo o vídeo e um exemplo de fala, e a IA cria um clipe onde os personagens “falam” de forma quase perfeita!

Os pesquisadores mostraram muitos exemplos que destacam as habilidades avançadas do MoCha. Os resultados são muito bons, com cenas em que protagonistas, sejam eles reais ou animados, falam exatamente as falas do áudio. A IA considera emoções e pode lidar com vários personagens ao mesmo tempo.

Apesar de tudo, os vídeos ainda apresentam algumas falhas. Movimentos dos olhos e dos rostos podem dar pistas de que estamos vendo algo criado por IA. Embora a sincronização labial com a fala esteja bem ajustada, a movimentação da boca é exagerada e não condiz com a naturalidade dos humanos.

Com a experiência que já tenho, vi muitos modelos semelhantes e alguns bem convincentes. Primeiro, vamos falar do Runway Gen-4, mencionado na semana passada. Os clipes de demonstração parecem mais aprimorados que o MoCha. Porém, MoCha tem potencial de melhorar quando for comercializado.

Partindo para outro modelo, sempre comparo novas ferramentas que sincronizam personagens gerados por IA com amostras de áudio com o VASA-1 da Microsoft, que foi apresentado em abril passado. O VASA-1 transforma fotos estáticas de pessoas em vídeos de personagens que falam, desde que você forneça um áudio.

A Microsoft nunca liberou o VASA-1 para o público, já que esse tipo de tecnologia pode ser muito mal utilizada. Por outro lado, o ByteDance, dono do TikTok, também apresentou uma IA parecida que transforma uma única foto em um vídeo totalmente animado.

Essa tecnologia, chamada OmniHuman-1, faz animações de movimentos do corpo, assim como vimos na demonstração do MoCha. Isso possibilitou ver a Taylor Swift cantando a música tema de Naruto em japonês. E sim, é um deepfake, já chego nesse ponto!

Ferramentas como VASA-1, OmniHuman-1 e MoCha, além do Runway Gen-4, podem ser usadas para criar deepfakes que confundirão muitos.

Os pesquisadores que estão à frente do MoCha e de outros projetos precisam discutir publicamente esses aspectos, especialmente quando o modelo for lançado comercialmente. Se você observar as amostras do MoCha disponíveis online, pode notar algumas inconsistências, mas se assistir no celular, essas falhas podem passar batido.

E dependendo do seu nível de compreensão sobre a geração de vídeos por IA, talvez você acredite que esses clipes foram realmente filmados com câmeras.

Outra questão importante é a divulgação dos dados usados para treinar essa IA. O estudo sobre o MoCha revelou que foram usados cerca de 500 mil amostras, somando 300 horas de vídeos de fala de alta qualidade, mas não informou a origem desses dados. Isso é um problema comum na indústria, onde a origem dos dados não é sempre informada, e isso levanta questões éticas.

A discussão sobre essas tecnologias é vasta e coloca em pauta a necessidade de supervisão e transparência no uso de dados para o treinamento de IAs, já que isso impacta diretamente na ética de como essas ferramentas são desenvolvidas e utilizadas.